目前大部分神经网络的计算都是在服务器进行。例如,当我们向ChatGPT(或者智能家电)提出问题时,设备需要几秒钟的时间才能做出响应。出现这种延迟的原因之一是联网设备没有足够的内存或电量来存储和运行设备理解用户要求所需的庞大机器学习模型。该模型存储在可能位于数千公里外的数据中心,在那里计算答案并将其发送到设备。该延时虽不大,但限制了很多需要实时反馈的场景,如自动驾驶。

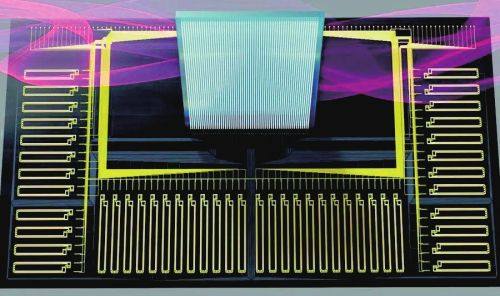

因此,麻省理工学院(MIT)的研究团队基于集成硅光芯片,创造了一种直接在这些设备上进行计算的新方法(光学边缘计算),从而大大减少了这种延迟。他们的技术将运行机器学习模型的内存密集型步骤转移到中央服务器,在中央服务器上模型的组件被编码到光波上。使用光纤将波传输到连接的设备,这使得大量数据能够通过网络以光带宽(2.4TB/s)发送。然后接收器使用一个简单的光学设备,该设备使用这些光波携带的模型部分快速执行计算。

与其他方法相比,该技术可将能源效率提高一百倍以上。它还可以提高安全性,因为用户的数据不需要传输到中央位置进行计算。这种方法可以使自动驾驶汽车实时做出决策,同时耗电量仅相当于计算机当前所需能量的1%。它还可以让用户与他们的智能家居设备进行无延迟对话,用于通过蜂窝网络进行实时视频处理,甚至可以在距离地球数百万英里的航天器上实现高速图像分类。

“每次你想运行一个神经网络,你都必须调用模型,你能以多快的速度运行这个程序取决于你能以多快的速度从内存中输入模型。我们的管道很大——相当于每毫秒左右通过互联网发送一部完整的电影。这就是数据进入我们系统的速度。而且它的计算速度也可以这么快。”MIT团队负责人德克·英格伦教授(Dirk Englund)说。

边缘计算(edge computing)是近年来人工智能芯片领域的热门方向之一。这种运算模式把神经网络运行在智能终端处理器比如智能手机、自动驾驶汽车上,通过实现去中心化计算,可以大大增加用户信息的安全性,同时减少数据中心的计算量,缩小数据处理的延时等。

谷歌推出的特种处理器芯片Edge TPU以及NVIDIA的EDX芯片等都是面向上述应用。然而,当电学芯片运算大规模权重矩阵时,其能量损耗和计算速度已经达到瓶颈,这影响了智能边缘设备的续航时间并会导致计算延时,进而增加智能终端的体积,重量和功率。麻省理工团队的光学服务器-客户端架构主要实现了:

(1)一个硅光集成芯片为基础的“智能发射器”(smart transceiver)用于电-光转换,通过波分复用把权重数据传输,用光纤传到毫瓦级别的终端处理器,其中的数据传送光学带

宽达到2.4THz(48通道,50GHz每通道)。(2)他们把AI模型从MIT校园传送到林肯实验室(86千米)的终端做计算。(3)该架构实现了99%的图像识别准确度。通过采用自制的光电积分器,乘法器的每次乘法运算低于一个光子数。

近日,相关论文以《在互联网边缘的单域光子深度学习》(Delocalized photonic deep learning on the internet's edge)为题发表在Science上。

亚历克斯·斯拉德斯是第一作者,瑞安·哈默利和德克·英格伦教授担任共同通讯作者,陈在俊为共同作者。

该研究始于2019年。陈在俊说:“Netcast是针对边缘运算提出的光学解决方法,它能提供实时运算并减少能量负荷,可被用于边缘运算的各个场景,包括智能传感、蜂窝网络通信、航空航天、智能家居等。实验过程中有几个标志性的里程碑。”

第一步,通过采用硅光芯片实现了高精确率的16波长的光学数据传输以及浮点数值乘法器,该计算精度在模拟计算里相对较高,可以满足几乎所有AI算法的需求。

第二步,他们把智能网络通过光纤进行长距离(86千米)传输到林肯实验室,并保持同样的计算精度。第三步,该团队采用单光子计数器,在实验里实现了平均低于一个光子数的乘法器。

另据悉,该项目得到进一步资助,目前MIT英格伦课题组和南加州大学陈在俊课题组正合作研发下一代高度集成的边缘计算芯片。

访谈

更多护航视频监控网络安全 做物联网安全的守护者 ——专访天防安全总经理段伟恒

在万物互联时代,网络安全的重要性日益凸显,尤其在快速发展的城市建设中,搭建的巨大物联网络对其安全保障…

做行业赋能者 HID迎接数字化浪潮新机遇 破解新挑战

今年3月份,全球可信身份解决方案提供商HID发布了最新的《安防行业现状报告》(以下简称“报告”),该报告…

数字化浪潮下,安防厂商如何满足行业客户的定制化需求?

回顾近两年,受疫情因素影响,包括安防在内的诸多行业领域都遭受了来自市场 “不确定性”因素的冲击,市场…