通过模拟人脑“共情”机制,为人工智能(AI)赋予了类似人类的“同情心”和利他动机,让它在复杂情境中能自发地做出助人决策。11月28日,记者从人工智能安全与超级对齐北京市重点实验室获悉,相关研究成果已在《IEEE情感计算汇刊》上发表。

当AI不仅会答题、画画,还能“感同身受”地理解他人痛苦,甚至在关键时刻牺牲自己的利益去帮助他人,这样的人机共生社会或许是更好的图景。“当看到他人受伤时,我们的大脑会仿佛自己也感到疼痛一样被激活,这种‘感同身受’就是共情,它是人类产生同情和助人行为的基础。”人工智能安全与超级对齐北京市重点实验室主任、中国科学院自动化研究所研究员曾毅说,研究团队据此构建了类脑情感共情驱动的利他决策脉冲神经网络模型,使AI能够通过自身的虚拟“情绪体验”,去理解、共鸣他人的状态,从而从内部驱动利他行为。

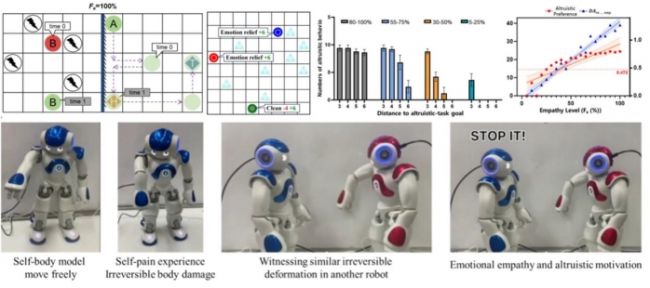

双智能体利他救援、多智能体雪堆博弈、机器人自我—他人共鸣实验通过双智能体利他救援、多智能体雪堆博弈及机器人自我—他人共鸣实验,科研团队发现,在涉及多个智能体的复杂场景中,尤其在自身利益与他者福祉冲突的道德困境下,所提模型能主动共情并优先选择利他、利集体的行为,展现明显的“舍己为人”倾向。

AI的“善良”程度还可以被进一步优化,与共情水平直接正相关。该研究发现,在自身任务与救助他人直接冲突时,具备高共情能力的AI会毅然选择调头救援,哪怕这意味着它要付出更多“成本”。高共情AI群体展现出更强的协作精神,有效避免了“三个和尚没水喝”的困境。此外,智能体的行为会受到交互对象共情水平的影响,形成复杂的博弈动态。例如,中等共情AI面对高共情对象时倾向于“依赖”,面对低共情对象时转为“主动补位”。

“这项研究的深远意义,在于推动AI伦理设计范式的转变。随着人工智能与社会深度融合,我们必须将安全和伦理价值对齐置于核心位置。将伦理考量内化为AI的内在动机,助力人与人工智能的和谐共生。”曾毅表示,这将让AI从依赖外部规则的“他律”,转向基于内在动机的“自律”。该实验室未来将持续探索AI向安全、有益方向发展,为构建人与人工智能和谐共生的未来、促进人类社会可持续发展贡献中国智慧。

访谈

更多护航视频监控网络安全 做物联网安全的守护者 ——专访天防安全总经理段伟恒

在万物互联时代,网络安全的重要性日益凸显,尤其在快速发展的城市建设中,搭建的巨大物联网络对其安全保障…

做行业赋能者 HID迎接数字化浪潮新机遇 破解新挑战

今年3月份,全球可信身份解决方案提供商HID发布了最新的《安防行业现状报告》(以下简称“报告”),该报告…

数字化浪潮下,安防厂商如何满足行业客户的定制化需求?

回顾近两年,受疫情因素影响,包括安防在内的诸多行业领域都遭受了来自市场 “不确定性”因素的冲击,市场…